1. Introduzione

La libertà di espressione di ogni cittadino e dei media svolge un ruolo fondamentale nella società. Essa è considerata uno dei pilastri di una società democratica e una condizione essenziale per garantire la tutela degli altri diritti umani.[1] Infatti, la libertà di ogni cittadino di esprimere liberamente le proprie idee permette di instaurare un dialogo positivo non soltanto a livello individuale, ma anche a livello collettivo, permettendo alla società nel suo insieme di rafforzare la parità dei diritti e la lotta contro le discriminazioni.[2]

Sebbene la libertà di espressione goda di un'ampia protezione come diritto fondamentale, non tutte le forme di espressione sono protette. Le limitazioni possono essere applicate secondo condizioni specifiche e in casi di contenuti specifici, come le “forme di espressione che diffondono, incitano, promuovono o giustificano l'odio basato sull'intolleranza”.[3] In questi casi, l'espressione dell'individuo può rientrare nella categoria del c.d. discorso di odio o, nella formulazione anglofona, di hate speech.

Numerose sono le definizioni di hate speech che emergono nel quadro del diritto europeo e internazionale.[4] Tuttavia, tali definizioni si concentrano su diversi aspetti che possono qualificare questo concetto. Tale disparità negli approcci e nelle caratteristiche selezionate ostacola il raggiungimento di un quadro giuridico uniforme e coerente a livello internazionale. Lo stesso vale anche per il contesto dell'Unione Europea, dove le disposizioni più rilevanti in materia di incitamento all'odio sono quelle contenute nella decisione quadro 2008/913/GAI del Consiglio sulla lotta contro alcune forme ed espressioni di razzismo e xenofobia attraverso il diritto penale.[5] Tale normativa rimane il punto di riferimento in questo ambito, per quanto altri strumenti giuridici abbiano affrontato la questione dei discorsi motivati dall'odio in aree specifiche, come la direttiva sui servizi di media audiovisivi 2018/1808/CE [6] e la direttiva sul commercio elettronico 2000/31/CE.[7]

Più recentemente, tuttavia, l'approccio delle istituzioni dell'UE in materia di incitamento all'odio (e più in generale anche di contenuti illegali) si è spostato dall'uso della c.d. hard law a quello della c.d. soft law: in particolare, verso l'uso di forme di co-regolamentazione, attraverso la quale la Commissione ha negoziato una serie di regole di comportamento con alcuni soggetti privati, in particolare le società che offrono servizi di comunicazione e informazione online. Questo approccio infatti parte dal presupposto che le società dopo aver partecipato alla redazione delle regole saranno maggiormente incentivate a rispettarle nella loro attività.[8]

Questo intervento presenta gli ultimi interventi del legislatore europeo sul tema del contrasto al discorso d’odio, lasciando la disamina dei profili più prettamente legati alla disciplina nazionale agli esperti che già hanno pubblicato in questa rivista.[9] Questo contributo, dunque, intende evidenziare i rischi e le difficoltà che la co-regolamentazione può incontrare in questo settore così sensibile, sia in ragione degli obiettivi di efficienza ed efficacia, tali da permettere una rapida reazione rispetto alla diffusione dei discorsi d’odio online, sia in ragione dell’obiettivo di salvaguardia della libertà di espressione stessa, evitando il rischio di assegnare un ruolo censorio ai soggetti privati coinvolti nella co-regolazione.

2. Una definizione di discorso dell'odio online

Il discorso dell'odio non è un fenomeno nuovo, piuttosto possiamo affermare che attraverso la comunicazione digitale il discorso d’odio ha trovato una nuova arena per la sua diffusione. Le caratteristiche dei social media aprono la strada a una più ampia diffusione di contenuti dannosi. La capacità di “condivisione” e i “like” possono portare ad un effetto moltiplicativo, tale da consentire ai contenuti di avere una «diffusione rapida e globale senza costi aggiuntivi per la fonte».[10]

Negli ultimi anni, c'è stato un significativo aumento nella presenza e diffusione dei discorsi di odio sotto forma di contenuti xenofobi, nazionalisti, islamofobici, razzisti e antisemiti nella comunicazione online.[11] Pertanto, la diffusione del discorso dell'odio online è percepita come un'emergenza sociale che può portare a conseguenze individuali, politiche e sociali. [12] Inoltre, l’attuale pandemia ha incrementato i sentimenti di ostilità nei confronti di stranieri, di cui hanno sofferto in particolare migranti e rifugiati, ma anche nei confronti delle categorie più deboli della popolazione, fra cui gli anziani.[13]

Il discorso dell'odio è generalmente definito come un discorso «progettato per promuovere l'odio sulla base della razza, della religione, dell'etnia o dell'origine nazionale» o di altre caratteristiche specifiche del gruppo.[14] Sebbene diversi trattati e accordi internazionali includano una regolamentazione del discorso dell'odio,[15] a livello europeo manca ancora un quadro di riferimento concordato, e, come anticipato sopra, l'unico punto di riferimento disponibile è la decisione quadro 2008/913/GAI. Tuttavia, il punto focale della decisione è il ravvicinamento delle legislazioni degli Stati membri relative a taluni reati di xenofobia e razzismo, mentre non contiene alcun riferimento ad altri tipi di motivazione, come il genere o l'orientamento sessuale. L'attuazione da parte degli Stati membri è stata meno efficace di quanto ci si aspettasse perché gli interventi legislativi nazionali hanno seguito approcci diversi: in alcuni casi attraverso l'inclusione del reato nel codice penale, in altri attraverso l'adozione di una legislazione speciale in materia. La scelta non è priva di effetti, in quanto le disposizioni procedurali applicabili alla legislazione speciale possono essere diverse da quelle applicabili ai reati inclusi nel codice penale.[16]

Dati i risultati insoddisfacenti emersi attraverso l’approccio di hard law, e la necessità di includere nella prospettiva anche i players internazionali - non soggetti in linea di principio alle norme europee, le istituzioni dell'UE sono passate a un approccio di soft law per quanto riguarda il discorso dell'odio (seguendo un trend già affermato anche per altri contenuti illegali).[17]

3. Le forme di co-regolazione nella lotta al hate speech

Il 30 maggio 2016 la Commissione ha adottato il Codice di condotta sulla lotta all'odio illegale online, firmato dai maggiori attori del mercato telematico: Facebook, Google, Microsoft e Twitter, cui si sono aggiunti nel 2018 anche Instagram, Google+, Snapchat, Dailymotion e jeuxvideo.com.[18] Il Codice di Condotta richiede ai firmatari di adattare le loro procedure interne per garantire una rapida ed incisiva risposta in caso di discorsi d’odio veicolati attraverso le rispettive piattaforme online. In particolare, il codice richiede che le società «valutino la maggior parte delle notifiche valide per la rimozione delle espressioni di odio illegale in meno di 24 ore e rimuovano o disabilitino l'accesso a tali contenuti, se necessario». Inoltre, i firmatari dovrebbero prevedere un sistema di notifica di rimozione che consenta loro di rivedere le richieste di rimozione «alla luce delle loro regole e delle linee guida comunitarie e, se necessario, delle leggi nazionali che recepiscono la decisione quadro 2008/913/GAI». [19]

Come è evidente, l'approccio adottato dalla Commissione europea è più incentrato sulla tempestiva rimozione del presunto discorso di odio che sulle garanzie procedurali che tale meccanismo di enforcement privato dovrebbe adottare per non limitare irragionevolmente la libertà di espressione degli utenti. Alla luce di tali obiettivi, possiamo osservare che le piattaforme online si sono progressivamente adeguate allo standard previsto. L'ultima valutazione degli effetti del Codice di condotta mostra un aumento del numero di notifiche che sono state valutate e rimosse in un lasso di tempo sempre più ridotto.[20]

Per raggiungere tali risultati, le aziende firmatarie hanno adottato una serie di strumenti tecnologici per valutare e riconoscere i contenuti caricati sulle loro piattaforme. [21] In particolare, hanno perfezionato gli algoritmi utilizzati in ciascuna piattaforma per individuare i contenuti potenzialmente offensivi. Infatti, secondo i dati forniti dalle aziende in merito ai contenuti segnalati, il solo lavoro umano potrebbe non essere in grado di raggiungere tale obiettivo. Tuttavia, tali algoritmi possono contrassegnare i contenuti solo sulla base di determinate parole chiave, che vengono continuamente aggiornate, ma sono sempre in ritardo rispetto all'evoluzione del linguaggio. E, cosa più importante, possono ancora interpretare in modo errato le parole chiave selezionate. Il discorso dell'odio è un tipo di linguaggio altamente sensibile al contesto, poiché la stessa parola può cambiare radicalmente il suo significato se usata in luoghi diversi nel corso del tempo. Un algoritmo che funziona solo attraverso la classificazione di alcune parole chiave non può raggiungere il livello di complessità del linguaggio umano e corre il rischio di produrre un alto numero di falsi positivi e negativi in assenza di comprensione del contesto nel quale i termini sono utilizzati. Per ovviare a tale problema, una strategia utilizzata dalle aziende è stata quella di includere una collaborazione fra l’algoritmo e l’intervento umano, non soltanto attraverso le segnalazioni operate dagli utenti individuali, ma attraverso forme di controllo dei contenuti sia interno che esterno. Nel primo caso, le aziende assegnano a team di dipendenti il compito di verificare i casi sensibili, in cui l'algoritmo non è stato in grado di individuare se il contenuto è contrario agli standard della comunità o meno. I dipendenti sono tenuti a valutare in tempi molto brevi i contenuti potenzialmente dannosi, al fine di fornire una decisione in merito all'opportunità di eliminarli. Questo fornirà poi un ulteriore feedback all'algoritmo, che ‘imparerà la lezione’.[22]

Il controllo esterno dei contenuti coinvolge invece i cosiddetti trusted flaggers, cioè individui o organizzazioni che si ritiene abbiano particolari competenze ed esperienza per riconoscere il discorso dell'odio. Gli esempi di tali trusted flaggers possono andare da organizzazioni della società civile e ONG, ad enti semipubblici, fino alle autorità pubbliche. [23]

4. Le questioni aperte dal Codice di condotta

4.1. Gli standard adottati dalle aziende

Sia gli algoritmi che gli esseri umani coinvolti nel rilevamento e nella rimozione dei contenuti per quanto riguarda il discorso dell'odio valutano i contenuti rispetto agli standard comunitari adottati da ogni piattaforma. Questi standard, tuttavia, non si sovrappongono completamente alla definizione legale fornita dal diritto comunitario, ai sensi della decisione quadro 2008/913/GAI.

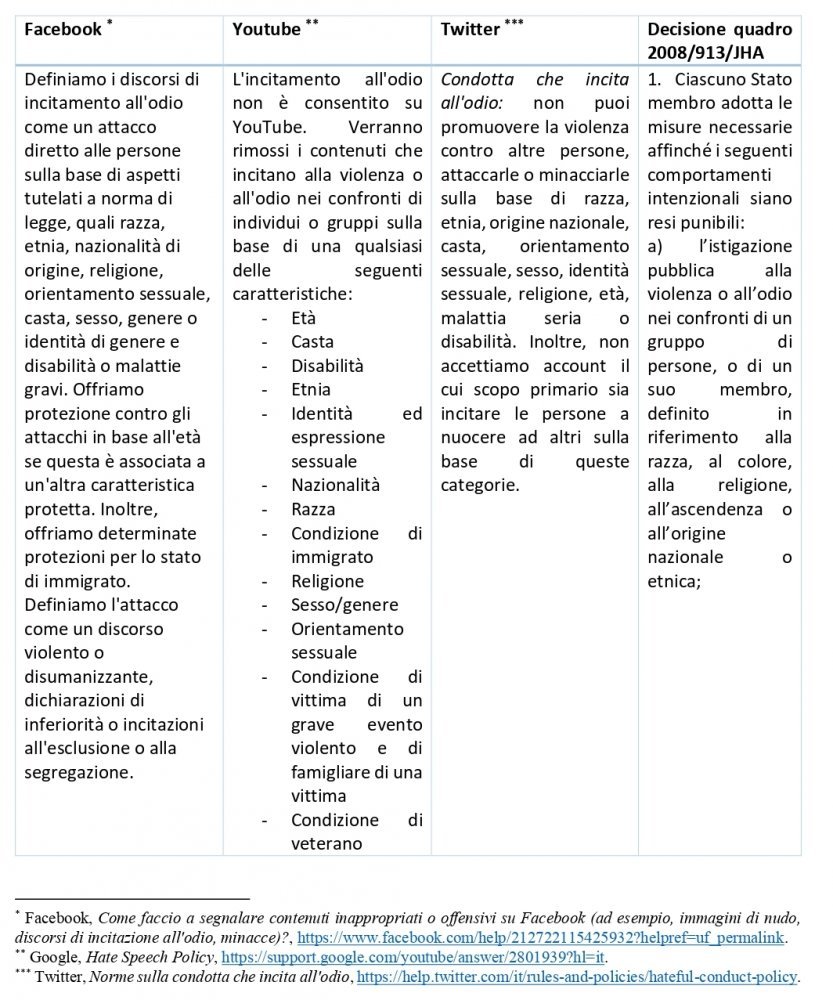

Come emerge dalla tabella 1, le definizioni fornite dalle aziende informatiche ampliano il campo di applicazione della Decisione quadro includendo divieti di incitamento all'odio in ragione del sesso, dell'orientamento sessuale, della disabilità o di malattie, dell'età, della condizione di veterano, ecc.

Tabella 1 – Le definizioni di discorso d’odio previste dalle piattaforme online

La scelta di ampliare il concetto di discorso d’odio ad aspetti ulteriori rispetto a quelli previsti dalla Decisione quadro può essere interpretata come il raggiungimento di un livello di protezione più elevato. Tuttavia, l'ampiezza della definizione non è sempre accompagnata da una successiva definizione altrettanto dettagliata degli specifici casi. Ad esempio, lo standard adottato da Youtube elenca una serie di caratteristiche sulla base delle quali il contenuto può essere ritenuto incitamento all’odio, fornendo alcuni esempi. Ma lo standard stabilisce solo due gruppi di casi: l'incoraggiamento alla violenza contro individui o gruppi sulla base delle caratteristiche segnalate da un lato, e dall’altro, la disumanizzazione di individui o gruppi, (per esempio chiamandoli subumani, paragonandoli ad animali, insetti, parassiti, malattie o qualsiasi altra entità non umana).[24] L’approccio di Facebook fornisce un esempio migliore in quanto include una descrizione più dettagliata dei crescenti livelli di severità legati a tre livelli di contenuto dei discorsi di odio. In ogni livello, vengono fornite parole chiave per mostrare il tipo di contenuto che sarà identificato (dagli algoritmi) come potenzialmente dannoso.[25]

Di conseguenza, l'inclusione di tali ampie definizioni di discorso dell'odio all'interno delle linee guida o degli standard comunitari diventa di fatto una regola di comportamento per gli utenti di tali servizi. Le piattaforme analizzate sono autorizzate a valutare come contrari alle proprie politiche sul discorso d’odio un'ampia gamma di contenuti, sebbene questi possano essere legalmente espressi alla luce dei criteri previsti della decisione quadro 2008/914/GAI.

Ciò ha due conseguenze: in primo luogo, la privatizzazione dei sistemi di enforcement a favore delle piattaforme private, anche per quanto riguarda quei comportamenti non coperti da disposizioni di legge con il rischio di un'eccessiva interferenza con il diritto alla libertà di espressione degli utenti. In tal senso, infatti, gli algoritmi utilizzati dalle società informatiche possono avere il potere di tracciare la linea, spesso sottile, tra il legittimo esercizio del diritto alla libertà di espressione e il discorso d’odio.

In secondo luogo, l’ampiezza dei contenuti potenzialmente dannosi porta a imporre nei confronti delle piattaforme un obbligo di controllo su tutto il flusso di comunicazione. Ciò può essere in conflitto con il regime di responsabilità adottato ai sensi del diritto comunitario in materia, in particolare la direttiva sul commercio elettronico, che impone una distinzione a tre livelli tra le responsabilità degli intermediari e, soprattutto, vieta qualsiasi obbligo generale di controllo sui fornitori di servizi Internet ai sensi dell'art. 15.[26] Come sarà affrontato nel prosieguo, il raggiungimento di un punto di equilibrio tra incentivi sufficienti a bloccare i contenuti dannosi e gli effetti di blocco eccessivo è fondamentale per salvaguardare la libertà di espressione degli utenti.

4.2. Garanzie del giusto processo

Come conseguenza dell'analisi precedente, emerge la questione delle garanzie procedurali degli utenti. Una prima questione è legata alla disponibilità di meccanismi interni che consentono agli utenti di essere informati sui contenuti ritenuti potenzialmente dannosi, di essere ascoltati e di poter ricorrere contro la decisione delle piattaforme. Sebbene la posizione più forte a tutela della libertà di espressione e del principio del giusto processo suggerisca che qualsiasi restrizione (cioè qualsiasi eliminazione di contenuti potenzialmente dannosi) debba essere soggetta all'intervento giudiziario,[27] il numero di decisioni adottate quotidianamente dalle società informatiche non può permettersi tale soluzione, né per le potenziali vittime e i potenziali trasgressori, né per il sistema giudiziario in quanto tale. Va notato che il Codice di condotta non prevede alcun requisito specifico né in termini di procedimenti giudiziari, né attraverso meccanismi alternativi di risoluzione delle controversie, per cui è lasciata alle società informatiche la facoltà di introdurre un meccanismo di ricorso.

Le salvaguardie per limitare il rischio di rimozione dei contenuti legali sono invece previste nella Raccomandazione della Commissione sulla lotta ai contenuti illegali online, che include nella più ampia definizione di contenuti illegali anche i discorsi di odio.[28] La raccomandazione punta all'individuazione e alla rimozione automatizzata dei contenuti e sottolinea la necessità di un contro-avviso in caso di rimozione di contenuti legali. Le procedure prevedono lo scambio tra l'utente e la piattaforma, che dovrebbe fornire una risposta: in caso di prove fornite dall'utente che il contenuto non può essere qualificato come illegale, la piattaforma dovrebbe ripristinare il contenuto che è stato rimosso senza indebito ritardo o consentire il ricarico da parte dell'utente; mentre, in caso di decisione negativa, la piattaforma dovrebbe includere le ragioni di tale decisione.

Tra i firmatari del codice di condotta, due sono le soluzioni adottate: Google prevede un meccanismo di revisione che consente agli utenti di presentare un ricorso contro la decisione di ritirare i propri contenuti caricati.[29] Successivamente, la valutazione delle giustificazioni fornite dall'utente viene elaborata internamente e la decisione finale viene inviata all'utente, con una spiegazione limitata o inesistente.

Un approccio diverso è adottato da Facebook. Nel settembre 2019 il social network ha annunciato la creazione di un "Oversight Board".[30] Il Board avrà il compito di fornire i ricorsi per i casi selezionati che riguardano contenuti potenzialmente dannosi. Sebbene il regolamento dettagliato relativo alle attività del consiglio sia ancora da redigere, è chiaro che non sarà in grado di esaminare tutti i contenuti oggetto di ricorso.[31] Sebbene questo approccio sia stato elogiato dagli studiosi,[32] rimangono aperte diverse questioni: la trasparenza nella selezione delle persone incaricate del ruolo di aggiudicazione, il tipo di spiegazione della decisione presa, il rischio di cattura (in particolare per il comitato di sorveglianza), e così via. E al momento, queste domande sono ancora senza risposta.

4.3. Il regime di responsabilità

Quando le piattaforme impiegano algoritmi (e/o trusted flaggers) per individuare e rimuovere in modo proattivo contenuti potenzialmente dannosi, possono correre il rischio di perdere l'esenzione dalla responsabilità prevista dalla direttiva e-Commerce, implementata in Italia con il D.lgs. 70/2003. Secondo l'art. 14 della direttiva, i fornitori di hosting sono esonerati dalla responsabilità quando soddisfano le seguenti condizioni:

- I fornitori di servizi prevedono solo la memorizzazione di informazioni su richiesta di terzi;

- il prestatore di servizi non svolge un ruolo attivo tale da consentirgli di conoscere o controllare tali informazioni.

Secondo la decisione della Corte di giustizia nella causa L'Oréal contro eBay,[33] la Corte di giustizia aveva affermato che ogni volta che una piattaforma online prevede la memorizzazione di contenuti (nel caso specifico le offerte di vendita), stabilisce le condizioni del servizio e riceve ricavi da tale servizio, ciò non modifica la sua qualificazione come hosting provider, imponendo un regime di responsabilità per i contenuti memorizzati. Tuttavia, l’esenzione di responsabilità potrebbe perdersi nel momento in cui l'hosting provider offra “un'assistenza che comporta, in particolare, l'ottimizzazione della presentazione delle offerte in vendita in questione o la promozione di tali offerte”. Ciò comporta che il ruolo attivo dell'hosting provider si ritrova solo quando interviene direttamente sui contenuti generati dall'utente. Questa distinzione è stata confermata anche dalla giurisprudenza italiana che ha progressivamente individuato gli elementi qualificanti i cd. Hosting attivo e passivo.[34]

In questo caso dunque sorge l’interrogativo: se l'hosting provider adotta misure tecniche per individuare ed eliminare i discorsi d'odio, può mantenere la sua posizione neutrale nei confronti dei contenuti?

L'esonero dalla responsabilità può comunque essere applicato solo se si applicano le altre due condizioni stabilite dall'art. 14 della direttiva sul commercio elettronico, ossia

- i fornitori di servizi di hosting non sono effettivamente a conoscenza dell'attività o delle informazioni illegali e, per quanto riguarda le richieste di risarcimento danni, non sono a conoscenza di fatti o circostanze da cui l'attività o le informazioni illegali sono evidenti o

- Una volta acquisita tale conoscenza o consapevolezza, essi agiscono rapidamente per rimuovere o disabilitare l'accesso alle informazioni.

Ne consegue che le misure proattive adottate dall'hosting provider possono far sì che la piattaforma in questione venga a conoscenza di contenuti illeciti, il che potrebbe comportare la perdita dell'esonero dalla responsabilità. Tuttavia, se l'hosting provider agisce rapidamente per rimuovere o disattivare l'accesso ai contenuti dopo aver acquisito tali conoscenze o consapevolezza, continua a beneficiare dell'esonero di responsabilità.

Da una prospettiva diversa, è possibile che lo sviluppo di strumenti tecnologici possa portare a un effetto inverso per quanto riguarda gli obblighi di controllo applicati alle imprese informatiche. Ai sensi dell'art. 15 della direttiva sul commercio elettronico, ai fornitori di servizi di hosting non può essere imposto alcun obbligo generale di controllo per quanto riguarda i contenuti illegali. In pratica, però, gli algoritmi possono già svolgere questo compito. Ciò legittimerebbe indirettamente gli obblighi di controllo applicati dalle autorità nazionali competenti?

Questa è la domanda posta da un tribunale austriaco alla CGUE per quanto riguarda i contenuti dei discorsi sull'odio pubblicati sulla piattaforma sociale Facebook. Il rinvio preliminare riguardava il seguente caso: nel 2016 l'ex leader del partito austriaco dei Verdi, Eva Glawischnig-Piesczek, è stata oggetto di una serie di post pubblicati su Facebook da un falso account. I post comprendevano commenti offensivi, in tedesco, sull’esponente politico associate alla sua immagine.

Sebbene Facebook si sia conformato all'ingiunzione del tribunale di primo grado per quanto riguardava l’area geografica austriaca, bloccando l'accesso all'immagine e ai commenti originali, la piattaforma ha presentato un successivo appello contro la decisione. Il caso ha poi raggiunto l'Oberste Gerichtshof (Corte Suprema austriaca) che ha analizzato il caso affermando il ruolo proattivo di Facebook nella pubblicazione dei commenti illeciti, tale da giustificare provvedimenti cautelari finalizzati alla verifica e alla cancellazione di ulteriori pubblicazioni di contenuti con formulazioni identiche o simili. Tuttavia, in questo caso, tale provvedimento potrebbe essere interpretato come un onere di monitoraggio, vietato non solo dall'art. 15 della direttiva sul commercio elettronico, ma dalla precedente giurisprudenza della CGUE. Pertanto, la Corte Suprema austriaca ha deciso di sospendere il procedimento e di presentare un rinvio pregiudiziale alla CGUE.

La Corte ha chiesto, in particolare, se l'Art. l'art. 15 (1) della direttiva sul commercio elettronico osti a che il giudice nazionale emetta un'ordinanza che imponga a un prestatore di servizi di hosting, che non ha provveduto a rimuovere rapidamente le informazioni illegali, di rimuovere non solo le informazioni specifiche, ma anche altre informazioni identiche nella formulazione?

La CGUE ha deciso la causa nell'ottobre 2019. La decisione ha sostenuto che, poiché Facebook era a conoscenza dell'esistenza di contenuti illegali sulla sua piattaforma, non poteva beneficiare dell'esenzione di responsabilità applicabile ai sensi dell'art. 14 della direttiva. In questo senso, la Corte ha affermato che, secondo il considerando 45 della direttiva, non si può impedire ai giudici nazionali di richiedere a un fornitore di servizi hosting di interrompere o impedire una violazione. La Corte ha poi seguito l'interpretazione dell'AG nella causa,[35] affermando che non vi è violazione del divieto dell'obbligo di controllo previsto dall'art. 14 della direttiva. L'art. 15 (1) della direttiva si applica nel caso in cui un’autorità nazionale imponga ad una piattaforma di fermare e prevenire un'attività illegale se esiste un rischio reale che le informazioni considerate illegali possano essere facilmente riprodotte. In tali circostanze, secondo la Corte, il provvedimento finalizzato ad impedire la pubblicazione di "informazioni con un significato equivalente" appare legittimo, altrimenti l'ingiunzione sarebbe stata semplicemente elusa.

Tuttavia, per quanto riguarda la portata dell'attività di monitoraggio assegnata al fornitore di hosting, la CGUE ha riconosciuto che l'ingiunzione non può imporre obblighi eccessivi a un intermediario e non può richiedere a un intermediario di effettuare una valutazione indipendente di contenuti equivalenti ritenuti illegali, per cui si potrebbero sfruttare tecnologie automatizzate al fine di rilevare, selezionare e rimuovere automaticamente contenuti equivalenti.

La decisione della CGUE cerca per quanto possibile di fornire un equilibrio tra la libertà di espressione e la libertà d'impresa, ma l'ampia interpretazione dell'art. 15 della direttiva può avere effetti negativi indiretti, in particolare se si considera l'opportunità per i social network di monitorare attraverso strumenti tecnologici il caricamento di informazioni identiche o equivalenti. Questo approccio ha si il pregio di salvaguardare gli incentivi per i fornitori di hosting a verificare la disponibilità di contenuti dannosi senza incorrere in ulteriori livelli di responsabilità. Tuttavia, l'utilizzo di strumenti tecnici potrebbe aprire la strada a ulteriori casi di falsi positivi, tali da rimuovere o bloccare i contenuti legalmente utilizzati, come ad esempio le segnalazioni giornalistiche su un post diffamatorio. E dunque aprendo di nuovo il problema di un ruolo di censore allocato alle piattaforme.

5. Conclusioni

Le manifestazioni di odio online non sono diverse da quello che possono trovarsi anche nella realtà, tuttavia il mezzo ne permette una rapidità di diffusione e una resistenza rispetto agli interventi di cancellazione tali da richiedere un intervento specifico che coinvolge non soltanto il legislatore, ma anche i soggetti che ne permettono la diffusione. Appare lapalissiano affermare che le principali piattaforme operanti sul mercato telematico hanno modificato l'ecosistema della comunicazione in gran parte del mondo, consentendo alle persone di connettersi in vari modi in tutto il mondo. Tuttavia, se da un lato le piattaforme operano come nuove arene pubbliche virtuali, ampiamente utilizzate da utenti singoli, associazioni ed anche partiti politici per veicolare i propri messaggi e le proprie opinioni, ciò non implica che tali piattaforme possano acquisire de plano la qualificazione di media al pari di carta stampata o televisione.[36]

L'intervento delle istituzioni nazionali e sovranazionali per limitare il discorso d’odio online però si scontra con le differenti interpretazioni di tale concetto. La Commissione Europea, al fine di superare tali differenze ed instaurare un dialogo con le piattaforme e le aziende operanti sul mercato ha adottato un approccio di co-regolazione che permetta di definire regole condivise.

Come chiarito sopra, questo approccio ha il vantaggio di incentivare il rispetto nei confronti delle regole condivise, a condizione che l’eventuale violazione non comporti alcuna responsabilità o sanzione. In questo modo, il rischio di censura collaterale può essere evitato o almeno ridotto. Ciononostante, esistono notevoli incentivi per eliminare contenuti non solo illegali, ma anche legali. Infatti, le linee guida e gli standard comunitari adottati dalle piattaforme si discostano dalla definizione di discorso dell'odio della Decisione Quadro e, anche fra loro, mancano di uniformità e chiarezza. Dunque, quando gli algoritmi applicano i criteri definiti sulla base di tali diversi concetti, possono limitare indebitamente la libertà di parola dell'utente.

L'approccio della Commissione, confermato dalla recente giurisprudenza europea, richiede esplicitamente un monitoraggio proattivo, ma questo impone di fatto obblighi di monitoraggio che possono essere realizzati attraverso strumenti tecnici, che sono ben lungi dall'essere privi di difetti e pregiudizi. Dal punto di vista tecnico, i livelli di efficacia, accessibilità e trasparenza dei meccanismi di controllo del discorso d’odio sono ancora inferiori alle aspettative, confermando che ancora la strada da percorrere è ancora lunga.

[1] Si veda anche G. Conti, Manifestazione del pensiero attraverso la rete e trasformazione della libertà di espressione: c'è ancora da ballare per strada?, in Rivista AIC, n. 4/2018, https://www.rivistaaic.it/it/rivista/ultimi-contributi-pubblicati/gian-luca-conti/manifestazione-del-pensiero-attraverso-la-rete-e-trasformazione-della-liberta-di-espressione-c-e-ancora-da-ballare-per-strada. In particolare l’Autore si sofferma sulla qualificazione della libertà di espressione nella giurisprudenza della Corte Costituzionale come «non tanto una materia, quanto una "condizione preliminare" per l'attuazione dei principi propri dello Stato democratico», cfr. Corte Costituzionale, decisione n. 312/2003. A livello internazionale, si veda UNESCO, Freedom of Expression: A Fundamental Human Right Underpinning All Civil Liberties, https://en.unesco.org/70years/freedom_of_expression.

[2] D. Kaye, Report of the Special Rapporteur on the promotion and protection of the right to freedom of opinion and expression, A/74/486, https://www.ohchr.org/Documents/Issues/Opinion/A_74_486.pdf.

[3] Gündüz v. Turkey, 2003-XI Eur. Ct. H.R. 76.

[4] Si vedano gli articoli 19 e 20 dell’International Covenant on Civil and Political Rights (1966) in cui si qualifica un divieto nei confronti di «[a]ny advocacy of national racial or religious hatred that constitutes incitement to discrimination, hostility or violence shall be prohibited by law»; nonchè l’art’4 dell’International Convention on the Elimination of Racial Discrimination (1965) in cui si richiede agli Stati firmatari di "declare an offence punishable by law all dissemination of ideas based on racial superiority or hatred, incitement to racial discrimination, as well as acts of violence or incitement to such acts against any race or group of persons of another colour or ethnic origin, and also the provision of any assistance to racist activities"; ed infine il c.d. Rabat Plan of Action on the prohibition of advocacy of national, racial or religious hatred that constitutes incitement to discrimination, hostility or violence (2013) in cui si identificano fra i criteri di valutazione dei contenuti potenzialmente dannosi I seguenti criteri: il contesto sociale e politico prevalente in quel momento; lo status del parlante; l’intenzionalità; in che misura contenuto e forma sono provocatori in modo diretto (e contano forma, stile, e natura di quanto scritto); l’ampiezza del pubblico raggiunto; la probabilità di causare rischi o danni imminenti. Inoltre, si veda l’ampia disamina volta da M. Castellaneta e P. De Sena, La libertà di espressione e le norme internazionali, ed europee, prese sul serio: sempre su Casapound c. Facebook, in SIDIblog, 20 Gennaio 2020, http://www.sidiblog.org/2020/01/20/la-liberta-di-espressione-e-le-norme-internazionali-ed-europee-prese-sul-serio-sempre-su-casapound-c-facebook/ , si veda anche M.E. Gamberini, Discriminazione, odio razziale e apologia del genocidio, 4 novembre 2013, in questa Rivista.

[5] Cfr. in generale la decisione quadro del Consiglio sulla lotta contro alcune forme ed espressioni di razzismo e xenofobia con mezzi di diritto penale, 2008 GU (L 328) 55 [di seguito "decisione quadro del Consiglio"].

[6] Direttiva 2018/1808, del 14 novembre 2018, relativa al coordinamento di determinate disposizioni legislative, regolamentari e amministrative degli Stati membri concernenti la fornitura di servizi di media audiovisivi (direttiva sui servizi di media audiovisivi) in considerazione delle mutevoli realtà del mercato, 2018 GU (L 303) 69, 92.

[7] Direttiva 2000/31/CE del Parlamento europeo e del Consiglio, dell'8 giugno 2000, relativa a taluni aspetti giuridici dei servizi della società dell'informazione, in particolare il commercio elettronico, nel mercato interno, 2000 GU (L 178) 1, 16.

[8] C. T. Marsden, Internet co-regulation: European law, regulatory governance, and legitimacy in cyberspace, 2011.

[9] F. Pallante, La propaganda nazi-fascista via social network e la Costituzione democratica antifascista, 20 gennaio 2020; F. Filice, Un'interessante decisione sulla legge Mancino. Nota a sentenza del Tribunale di Vercelli del 24 maggio 2017.

[10] K. Kaesling, Privatising Law Enforcement in Social Networks: A Comparative Model Analysis, 11 ERASMUS L. REV. 151, 151 (2018) in cui l’Autrice affronta in dettaglio l'intersezione tra social media e libertà di espressione.

[11] Si veda in generale Commissione Europea, Media Pluralism and Democracy, 452 final (5 gennaio 2017), https://op.europa.eu/en/publication-detail/-/publication/74281af8-d3dc-11e6-ad7c-01aa75ed71a1/language-en; vedi anche ARTICLE 19, Responding to ‘hate speech’: comparative overview of six EU countries (2018), https://www.article19.org/wp-content/uploads/2018/03/ECA-hate-speech-compilation-report_March-2018.pdf.

[12] Cfr. comunicato stampa della Commissione europea IP/18/1169, Un'Europa che protegge: La Commissione rafforza la risposta dell'UE ai contenuti illegali online (1 marzo 2018).

[13] Si veda l’intervento del Segretario Generale dell’ONU António Guterres per affrontare e contrastare i discorsi di odio legati alla pandemia, disponibile all’indirizzo https://unric.org/it/covid-19-appello-globale-del-segretario-generale-antonio-guterres-per-affrontare-e-contrastare-i-discorsi-di-odio-legati-alla-pandemia/

[14] Cfr. M. Rosenfeld, Hate speech in constitutional jurisprudence: A Comparative Analysis, 24 CARDOZO L. REV. 1523, 1523 (2003). Cfr. in generale T. Gillespie, Custodians of the internet: platforms, content moderation, and the hidden decisions that shape social media (2018), in cui viene presentata un'indagine su come le piattaforme dei social media predispongono i rispettivi sistemi di enforcement.

[15] Si noti che le definizioni di discorso dell'odio fornite a livello internazionale, si concentrano su diversi aspetti di questo concetto, guardando al contenuto e al modo di parlare, ma anche all'effetto e alle conseguenze del discorso.

[16] Si veda Commissione Europea, Relazione sull’attuazione della decisione quadro 2008/913/GAI del Consiglio sulla lotta contro talune forme ed espressioni di razzismo e xenofobia mediante il diritto penale, Bruxelles, 27.1.2014 COM(2014) 27 final. Si veda peraltro, A. Ciervo, Quale condanna per i negazionisti? Alcune riflessioni sul recente ddl in materia di "negazionismo", 18 dicembre 2013, in questa Rivista.

[17] Si veda, ad esempio, la dichiarazione della Commissione europea 19/2174, Codice di condotta contro l'informazione: Commissione accoglie con favore l'impegno delle piattaforme online in vista delle elezioni europee (22 aprile 2019) (che descrive i recenti interventi sulle notizie false e sui contenuti illegali online); cfr. anche la raccomandazione della Commissione del 1 marzo 2018 sulle misure per contrastare efficacemente i contenuti illegali online (1 marzo 2018) [di seguito "raccomandazione della Commissione"].

[18] Si veda il comunicato stampa della Commissione europea IP/16/1937, La Commissione europea e le aziende IT annunciano il Codice di condotta sul discorso dell'odio illegale online (30 maggio 2016) [di seguito Codice di condotta sul discorso dell'odio illegale online]; si veda anche Contrastare il discorso dell'odio illegale online #NoPlace4Hate, Commissione Europea (18 marzo 2019), https://ec.europa.eu/newsroom/just/item-detail.cfm?item_id=54300.

[19] Codice di condotta sul discorso di odio online illegale, punto 15.

[20] Vedi Commissione Europea, Progress on combating hate speech online through the EU Code of conduct 2016-2019, 27 Settembre 2019, https://ec.europa.eu/info/sites/info/files/aid_development_cooperation_fundamental_rights/assessment_of_the_code_of_conduct_on_hate_speech_on_line_-_state_of_play__0.pdf («On average, IT companies are now assessing 89% of flagged content within 24 hours, up from 81% one year ago. […] The removal rate is now stable at more than 70% on average. In 2016, after the first monitoring exercise on the implementation of the Code of conduct only 28% of the content flagged was removed. The current average removal rate can be considered as satisfactory in an area such as hate speech, given that the line against speech that is protected by the right to freedom of expression is not always easy to draw and is highly dependent on the context in which the content was placed»).

[21] Si veda S. Cao, Artificial Intelligence Hate Speech Detector di Google, Google's Artificial Intelligence Hate Speech Detector Has a 'Black Tweet' Problem, OBSERVER (13 agosto 2019, 8:30 AM), https://observer.com/2019/08/google-ai-hate-speech-detector-black-racial-bias-twitter-study/.

[22] Ciò è confermato dalle stesse aziende che operano attraverso questi sistemi di controllo, come affermato dallo stesso CEO di Facebook, Mark Zuckerberg riconoscendo che lo spostamento verso l’uso quasi esclusivo di AI per il controllo dei contenuti (dovuto all’impossibilità di fruire dei servizi di controllo di moderatori umani causa Coronavirus) avrebbe portati ad un numero molto elevato di falsi positivi. Si veda T. Hatmaker, The pandemic is already reshaping tech’s misinformation crisis, in Techcrunch, 3 aprile 2020, https://techcrunch.com/2020/04/03/the-pandemic-is-already-reshaping-techs-misinformation-crisis/

[23] Ad esempio, Youtube definisce i trusted flaggers come utenti individuali, agenzie governative e ONG che hanno dimostrato le proprie competenze e (già) segnalano frequentemente contenuti con un alto tasso di accuratezza. È interessante notare che Youtube non delega completamente il controllo dei contenuti ai trusted flaggers, ma afferma piuttosto che «i contenuti segnalati da trusted flaggers non sono automaticamente rimossi o soggetti ad alcun trattamento di politica differenziale - gli stessi standard si applicano ai flag ricevuti da altri utenti. Tuttavia, a causa del loro elevato grado di accuratezza, i flag di Trusted Flaggers sono prioritari per la revisione da parte dei nostri team».

[24] Article 19, YouTube Community Guidelines: Analysis Against International Standards on Freedom of Expression, (2018), https://www.article19.org/resources/youtube-community-guidelines-analysis-against-international-standards-on-freedom-of-expression/.

[25] Article 19, Facebook Community Standards: Analysis Against International Standards on Freedom of Expression, (2018), https://www.article19.org/resources/facebook-community-standards-analysis-against-international-standards-on-freedom-of-expression/.

[26] Sull’applicazione delle norme relative alla responsabilità dell’ISP si veda M. Montanari, La responsabilità delle piattaforme on-line (il caso Rosanna Cantone), in Diritto dell'Informazione e dell'Informatica, 2/2017, p. 254.

[27] Si veda in tal senso il suggerimento dell’UN Rapporteur F. La Rue, nel Report of the Special Rapporteur on the Promotion and Protection of the Right to Freedom of Opinion and Expression, (2011), https://www2.ohchr.org/english/bodies/hrcouncil/docs/17session/A.HRC.17.27_en.pdf, p.13.

[28] Raccomandazione della Commissione 2018/334 sulla lotta ai contenuti illegali online, C/2018/1177, OJ L 63, 6.3.2018, pp. 50–61.

[29] Google, ‘Appeal Community Guidelines actions’ https://support.google.com/youtube/answer/185111.

[30] Per un’analisi del ruolo e delle competenze allocate a questo organo si veda Facebook, Establishing Structure and Governance for an Independent Oversight Board, in Facebook Newsroom, 17 Settembre 2019, https://newsroom.fb.com/news/2019/09/oversight-board-structure/ e ’Oversight Board Charter’, in Facebook Newsroom, 19 September 2019, https://fbnewsroomus.files.wordpress.com/2019/09/oversight_board_charter.pdf.

[31] Le cifre fornite da Facebook possono chiarire il problema: il numero di membri dell’Oversight Board è attualmente fissato a quaranta persone, mentre il numero di casi in appello ogni anno da parte di Facebook è di 3,5 milioni (solo in relazione al tema dei discorsi dell'odio), secondo il Community Standards Enforcement Report del 2019, https://transparency.facebook.com/community-standards-enforcement#hate-speech.

[32] In particolare, K. Klonick, Does Facebook’s Oversight Board Finally Solve the Problem of Online Speech?, in Centre for International Governance Innovation, Models for Platform Governance, 2019, p. 51, http://www.zbw.eu/econis-archiv/bitstream/handle/11159/3657/Platform-gov-WEB_VERSION.pdf?sequence=1#page=53. Ma si vedano i dubbi sollevati da M. Maroni, Some reflections on the announced Facebook Oversight Board, Robert Schuman Centre for Advanced Studies, Centre for Media Pluralism and Media Freedom (CMPF), 17 Ottobre 2019, https://cmpf.eui.eu/some-reflections-on-the-announced-facebook-oversight-board/.

[33] CGUE, Caso C-324/09 L’Oréal SA e al. contro eBay International AG e al. [2011] ECR I-06011.

[34] Si veda E. Tosi, Contrasti giurisprudenziali in materia di responsabilità civile degli hosting provider — passivi e attivi — tra tipizzazione normativa e interpretazione evolutiva applicata alle nuove figure soggettive dei motori di ricerca, social network e aggregatori di contenuti, in Riv. di Dir. Ind., 2017, fasc. 1, pag. 75; V. Franceschelli-O. Pollicino-E. Bertolini, Analysis of ISP Regulation Under Italian Law, in G.B. Dinwoodie (a cura di), Secondary Liability of Internet Service Providers, London, 2017, 141 ss.; M Bassini, Mambo Italiano: the Italian perilous way on ISP liability, in T. Ojanen e B. Petkova (a cura di), Fundamental Rights Protection Online: The Future Regulation of Intermediaries, London, in corso di pubblicazione. In particolare, si vedano le sentenze App. Milano sez. I civ. 7 gennaio 2015 in Resp. civ. prev., 2015, fasc. 4, p. 1261 (con nota di L. Bugiolacchi, Ascesa e declino della figura del “provider” “attivo”? Riflessioni in tema di fondamento e limiti del regime privilegiato di responsabilità dell'”hosting provider”); Ord. Trib. Milano sez. I civ. 25 maggio 2013 in Resp. civ. prev., 2013, 6, 1997 (con nota L. Bugiolacchi, Evoluzione dei servizi di “hosting provider”, conseguenze sul regime di responsabilità e limite dell'attuale approccio “case by case”); e più recentemente Corte di Cassazione, sez. I civile, 21 febbraio 2018, n. 7708 (con nota M. Bassini, La Cassazione e il simulacro del provider attivo: mala tempora currunt, in Rivista Medialaws, 2/2019, p. 248); e Tribunale di Roma, sez. XVII civile, 10 gennaio 2019, n. 693 (con nota F. Frigerio, Attivo, anche se inconsapevole. Il Tribunale di Roma sanziona Vimeo e conferma i caratteri della responsabilità dell’hosting provider attivo per violazione del diritto d’autore altrui, in Rivista Medialaws, 2/2019, p. 258).

[35] Si veda M. Monti, La Corte di giustizia, la Direttiva E-Commerce e il controllo contenutistico online: le implicazioni della decisione C 18-18 sul discorso pubblico online e sul ruolo di Facebook, in Rivista Medialaws, 3/2019, p. 243.

[36] Equivalenza che emerge tuttavia da una recentissima decisione cautelare dei Tribunale di Roma, Sez. Imprese, ordinanza 12 dicembre 2019. Si veda il commento di P. Falletta, Controlli e responsabilità dei social network sui discorsi d’odio online, Rivista Medialaws, 1/2020, p. 146.